10块钱在线租用GPU服务器体验部署清华大学开源项目ChatGLM-6B

大家好我是图恩,最近了解到网上有租用GPU的平台,可以以小时或者包月的形式体验高内存高显存服务器,适合一些做科研的同学和想要体验高配置的同学,因为正常情况下如果自己去买这种配置的电脑或者服务器价格是非常高的,现在有这么一个平台(featurize)可以按每小时2块钱左右的价格提供服务,已经是非常的优惠了。

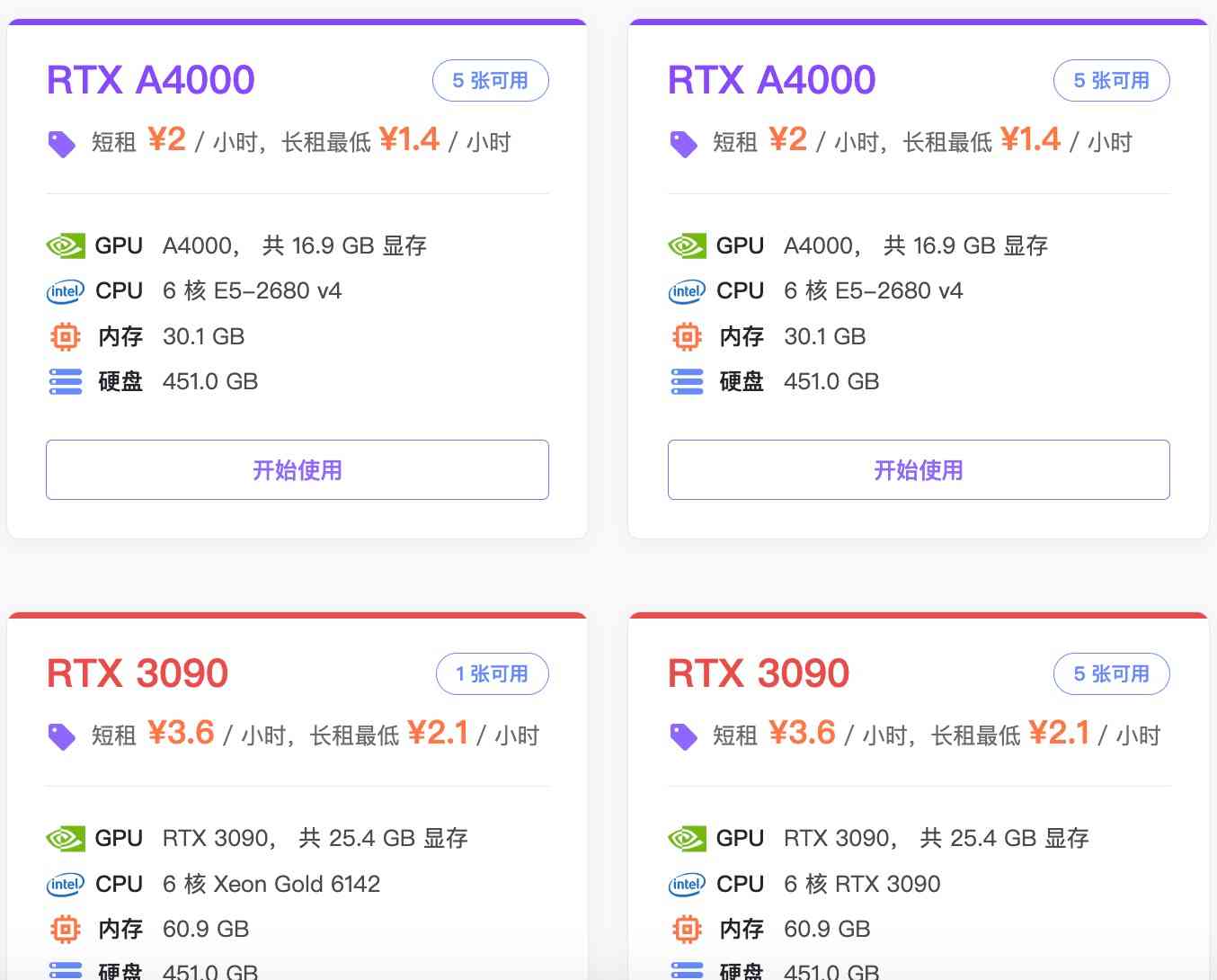

所以我在上周也体验了一番,充值了十块钱,租用了一个3090的gpu服务器,配置如下:

GPU RTX 3090, 共 25.4 GB 显存

CPU 6 核 RTX 3090

内存 60.9 GB

硬盘 451.0 GB与家庭电脑相比这些服务器的内存跟显存都非常高,特别适合跑一些需要高显存和内存的程序,比如gpt。

所以就找到前段时间清华大学开源的对标chatgpt的大语言模型项目ChatGLM-6B。

按照官网的说法最低只需要14的显存就能运行,以下为运行步骤:

下载代码仓库

git clone https://github.com/THUDM/ChatGLM-6B

cd ChatGLM-6B安装依赖,在当前根目录下之行以下命令:

pip install -r requirements.txt 启动模型,之行根目录下的启动文件:

python cli_demo.py启动过程中会去huggingface下载模型数据,大概好几个g,下载的时候又体现这个平台的优势了,因为下载速度非常快,可以达到上百兆,同时启动的实例又预先安装好了环境,按照官网的步骤一次就安装成功了,期间并没有报错。

启动完成就可以进行对话了,输入你想问的问题就可以得到相应的回答,随着你问的问题的增多,你可以看到上方的显存使用率会不断增加,因为如果你不清除之前的回答,那么你后续的提问跟回答都会再次作为提问输入从而导致需要的显存算力急剧增加。

好在模型给我们提供了一个clear命令,当你的显存不够时可以通过这个命令释放显存,否则会因为显存耗尽导致程序停止。

发表评论 (审核通过后显示评论):